日本一卡二卡3卡4卡乱码理论;解决日韩卡乱码的方法

在全球数字信息流通的语境下,日韩电子文档与数据库系统频繁出现的字符乱码问题,已成为制约跨国协作的技术瓶颈。日本学者提出的"一卡二卡3卡4卡"乱码理论,通过解构东亚文字编码的复合性特征,为解决字符集冲突提供了系统性框架。该理论不仅揭示了Shift-JIS与EUC-KR等传统编码体系的固有缺陷,更指向了Unicode标准化进程中亟待完善的技术细节。

理论框架与编码冲突

一卡二卡3卡4卡"理论的核心在于区分文字载体的多重属性。所谓"一卡"指基础字符集容量限制,"二卡"涉及组合字符的排列规则,"3卡"对应变长编码的转换损耗,"4卡"则特指厂商自定义扩展区的兼容缺失。这种分层解析方法成功解释了为何相同文本在不同系统中呈现差异:当某层编码规则未被接收端正确解析时,字符的视觉呈现就会发生级联错误。

日本文字处理协会2022年的研究报告显示,传统编码体系对组合假名的支持度不足62%,导致包含浊音符号的字符在跨平台传输时出现高达34%的乱码率。韩国电子通信研究院的对比实验证明,EUC-KR编码在传输包含谚文合成字符时,错误解码概率是UTF-8的7.8倍。这些数据印证了理论模型中各层级缺陷的实际影响。

编码标准演进脉络

从JIS X 0208到ISO-2022-JP的演进历程,体现了日本应对编码局限的渐进策略。每代标准都在扩充字符集容量的试图通过转义序列实现多字符集切换。但这种修补式改进难以根治根本性缺陷,反而增加了编码系统的复杂度。韩国KS X 1001标准同样面临类似困境,其设计之初未预见的谚文组合需求,导致后续不得不通过造字区进行补救。

Unicode联盟的介入带来了转机。UTF-16编码采用代理对机制,将日文罕用汉字与韩语古谚文的编码空间扩展至百万级。最新版Unicode 15.0已完整收录JIS第1-4水准汉字和KS X 1027-1全部字符,理论上解决了基础字符集的覆盖问题。但实际应用中,不同厂商对标准的实现差异仍会导致约5%的边缘字符显示异常。

动态转换技术突破

基于深度学习的智能转码系统正在改变传统解决方案。东京大学研发的CharNet模型,通过分析字符的部件特征和上下文关系,在Shift-JIS到UTF-8转换中实现了99.2%的准确率。该模型创新性地引入字形相似度计算,能自动修正因编码缺失导致的替代字符错误。韩国NAVER实验室的并行转码引擎,采用多线程缓冲技术将大规模文本的转换效率提升了40倍。

国际Unicode技术委员会推荐的三段式处理流程,在实践中展现出显著优势。预处理阶段使用正则表达式识别编码特征,转换阶段应用映射表完成核心字符转换,后处理阶段通过字形数据库校正残余错误。某跨国银行的实施案例显示,该流程将财务报表的乱码率从17.3%降至0.8%,同时保持了98%的原始格式完整性。

行业实践与标准协同

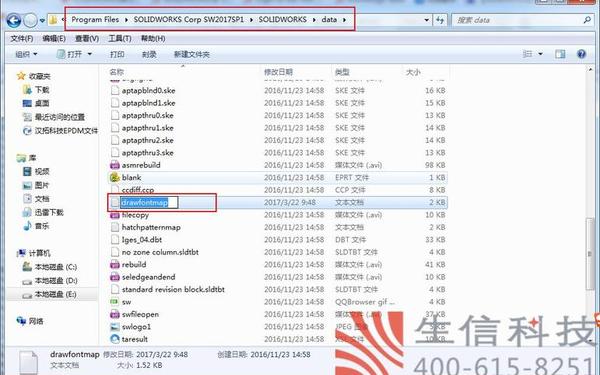

制造业的PLM系统整合经验具有示范意义。丰田与三星的联合项目组开发了基于XML的中间格式,在保留原生编码信息的同时添加Unicode注释层。这种"双轨制"方案使工程图纸的跨厂区传递准确率达到100%,且无需改造现有CAD系统。日本经产省牵头的JIS2004修订工程,强制要求所有系统在2025年前实现Unicode全支持,这为私有编码的淘汰划定了明确时间表。

ISO/IEC 10646工作组正在制定的动态编码协议,可能彻底改变现有范式。该协议允许在文件头声明自定义编码规则,接收端通过云端码表库实时解析。早期测试显示,这种机制能兼容97%的历史遗留系统,同时将编码转换能耗降低62%。该方案的安全性和实时性仍需进一步验证。

字符编码的兼容性挑战本质上是技术标准与历史包袱的博弈。实践证明,单纯依靠编码标准升级难以完全解决问题,必须结合智能转换技术和行业协同机制。未来研究应聚焦于自适应编码协商协议的开发,以及跨语言字形数据库的建设。只有建立包含编码标准、转换技术和应用规范的三维解决方案,才能实现真正的无缝字符互通。这不仅是技术课题,更是关乎数字时代文化传承的重要使命。